ChatGPTやその他のAIチャットボットを日常的に使っている方は急増しています。しかし最近、OpenAIのサム・アルトマンCEOが行った発言が大きな波紋を呼んでいます。「ユーザーとChatGPTの会話データは、法的手続きや訴訟時には開示される可能性がある」という警告を発したのです。

この発言をきっかけに、AIチャットボットのプライバシー問題について改めて注目が集まっています。そこで、ChatGPTを安全に使うために知っておくべきプライバシーリスクと対策について詳しく解説していきます。

アルトマンCEOの警告が意味するもの

AI業界のトップが自ら認めた、ChatGPTの法的保護の欠如について詳しく見ていきましょう。

2025年7月にコメディアンのTheo Vonが主宰する「This Past Weekend」ポッドキャストにOpenAIのサム・アルトマンCEOが出演し、ChatGPTとの対話には「弁護士や医師などの専門家との会話のような法的な守秘義務特権がない」と明言しました。これは、法的・倫理的観点から極めて重要な発言です。

つまり、ユーザーがChatGPTに相談した内容は、裁判や捜査などの法的手続きにおいて、証拠として開示される可能性があるということ。個人的な悩みやビジネスの機密情報を気軽に入力していた方にとっては、ちょっとショッキングな話かもしれません。

実際に日本の法律でも、現時点(2025年)ではAIとの会話内容に対する十分なプライバシー保護は提供されていないのが現状です。

ChatGPTに潜む「見えない危険」とは?

普段何気なく使っているChatGPTには、実は知られざるリスクが潜んでいます。

まず最も基本的な問題として、ChatGPTなどのAIチャットボットに入力した内容は、基本的に外部のサーバー(OpenAIのサーバー)に送信・保存されているということがあります。これって意外と知らない方も多いんですよね。

入力されたデータは、モデルの改善や学習材料として再利用される可能性があります。さらに、サービス運用の最適化や、他のユーザーへの回答生成時の参考データとして活用されることもないとは言い切れません。つまり、ユーザーが何気なく入力した内容が、知らないうちに他の人への回答に影響を与えているかもしれないということです。

それから、会話履歴を削除したり、プライバシー設定で学習に使わないよう設定したりしても、完全な消去が保証されていないという問題もあります。一度システムに記録されたデータの痕跡が残っている可能性は否定できません。これは結構怖い話ですよね。

さらに深刻なのが、前述したアルトマンCEOの発言通り、OpenAIのプライバシーポリシーには「法令順守・第三者への法的開示義務」がしっかりと明記されていることです。つまり、裁判や捜査などで必要と判断されれば、当局にデータを提供する可能性があるということ。個人的な相談内容が法廷で証拠として使われる可能性もゼロではないんです。

企業利用でのリスクは特に深刻

個人利用以上に深刻なのが、企業でのChatGPT利用におけるリスクです。実際に韓国のサムスン電子では、2023年3月に社外秘情報をChatGPTに入力してしまい、情報漏洩事故が発生した事例があります。

この事件は、同社が半導体部門でChatGPTの利用を解禁(3月11日)してから、わずか20日間で3件もの情報漏洩インシデントが確認されたという深刻なものでした。業界内でも大きな話題となり、その後多くの企業がAI利用のガイドライン見直しを迫られることになったんです。

企業が日常業務でChatGPTを使う際、うっかり入力してしまいがちなのが業績や事業計画などの機密情報です。顧客の個人情報や特許・技術情報、M&Aなどの重要な経営判断に関する情報なども同様ですね。営業担当者が提案資料を作る際に競合他社の情報を入力したり、人事担当者が採用計画について相談したりと、業務の効率化を図ろうとする過程で機密情報が漏れてしまうケースが想定されます。

特に怖いのは、これらの情報が意図せず学習データとして利用されたり、他の企業への回答で露出したりするリスクです。競合他社が同じような質問をした際に、あなたの会社の機密情報がヒントとして表示されてしまう可能性もゼロではありません。企業にとっては、これは致命的な問題となる可能性が高いですよね。す。

最新のセキュリティ脅威も増加中

2023年から2025年にかけて、AIに関連した新しいタイプの犯罪やセキュリティ脅威も頻発しています。

フィッシング詐欺の巧妙化

まず注意したいのが、フィッシング詐欺の巧妙化です。AIを使って作成されたメールや偽サイトは、従来のものと比べて格段に自然で説得力があるため、見分けることが非常に困難になっています。文章の不自然さで判断していた従来の対策では、もはや対応しきれない状況なんですね。

アカウント情報の流出問題

認証情報の流出も深刻な問題となっています。ChatGPTのアカウント情報がダークウェブで売買されているケースも確認されており、日本からも相当数の情報が漏洩していることが判明しています。一度アカウントが乗っ取られると、そこに保存されている会話履歴すべてが第三者に閲覧される可能性があります。

API不正利用による被害

さらに、API不正利用による被害も増加傾向にあります。企業のAPIキーが不正に取得・悪用されることで、大量のリクエストが送信され、想定外の料金が請求されるケースが報告されています。また、不正利用されたAPIを通じて機密情報が抜き取られる危険性もあるため、API管理の重要性が高まっています。

AIによる偽情報の拡散

AIによる偽情報の拡散も見過ごせない問題です。非常にリアルな偽のニュース記事や画像、音声が簡単に作成できるようになったため、情報の真偽を見極めることがこれまで以上に困難になっています。

スタンフォード大学のAIインデックスレポート2025によれば、AI関連インシデントの増加に加え、企業の約3分の1が十分な対策を講じていない実態も明らかになっています。つまり、多くの組織がこれらの新しい脅威に対して準備不足の状態にあるということですね。

個人ユーザーができる具体的な対策

それでも、多くの方はChatGPTなどの生成AIサービスを使い続けたいですよね。ここではChatGPTを例にし、すぐに実践できる対策を紹介します。

基本的な安全対策

ChatGPTを使う場合は次のような対策を頭に入れておくのがおすすめです。

入力前の情報判断を習慣化する

まず最も重要なのが、入力前の情報判断です。ChatGPTに何かを入力する前に、「この情報が外部に漏れても大丈夫?」「将来的に法的な問題で開示されても問題ない?」を必ず自問する習慣をつけましょう。これは面倒に感じるかもしれませんが、一度習慣化してしまえば自然にできるようになります。迷った時は入力しないという判断も大切ですね。

入力する情報を次のように分類して判断するのがおすすめです。

| 分類 | 内容例 | ChatGPT利用 |

|---|---|---|

| 公開OK | 一般的な質問、学習内容 | ◯ |

| 注意が必要 | 仕事の相談、軽い悩み | 慎重に判断 |

| 絶対NG | 個人情報、機密情報、法的問題 | × |

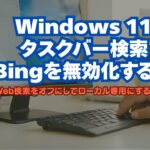

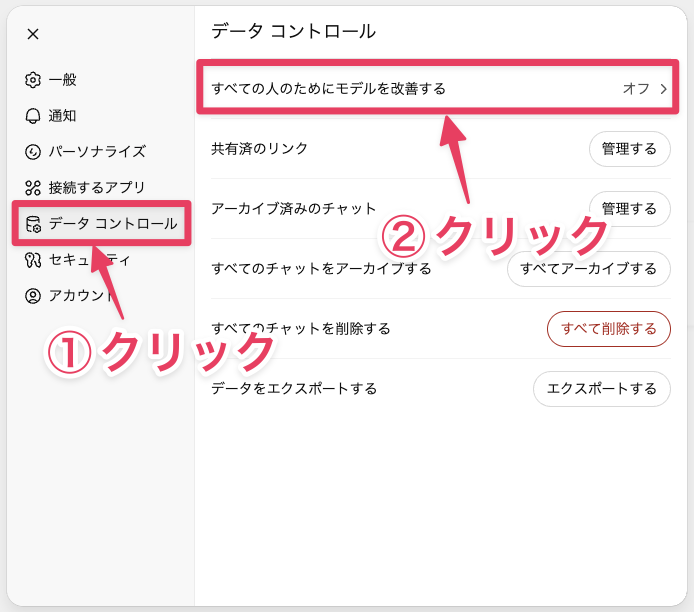

オプトアウト設定を有効にする

次に、オプトアウト設定の活用について。ChatGPTには、入力したデータを学習データとして使用しない設定があります。

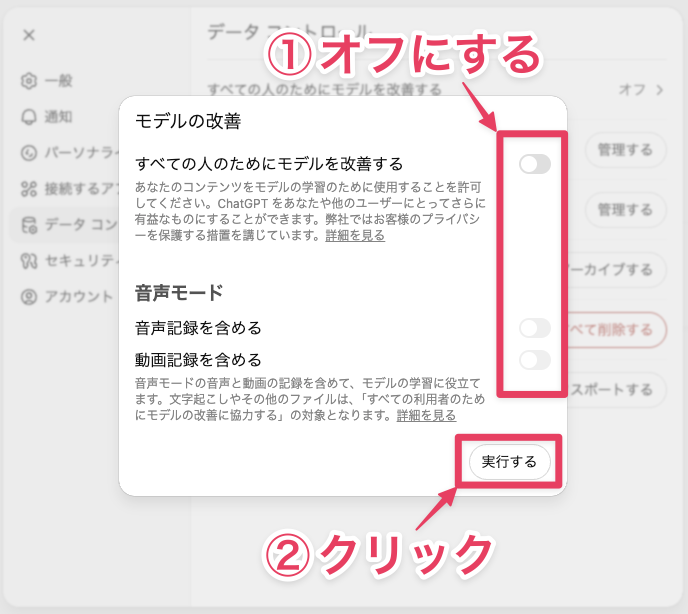

サイドバーの下にあるアカウント名→「設定」をクリックすると、設定ダイアログが表示されます。ここで、「データコントロール」→「すべての人のためにモデルを改善する」をクリックします。

表示された設定項目をすべてオフにし、「実行する」をクリックすることで、自分の会話がAIの学習に使われるリスクを大幅に減らせます。

この設定は一度行えば継続されるので、まだ設定していない方は今すぐ確認してみてください。なお、他の生成AIの場合、同様の設定があるものとないものがあります。

会話履歴とメモリを定期的に削除する

履歴の定期削除も重要な対策です。ChatGPTには「会話履歴」と「メモリ機能」という2つの記録システムがあるため、両方を適切に管理する必要があります。

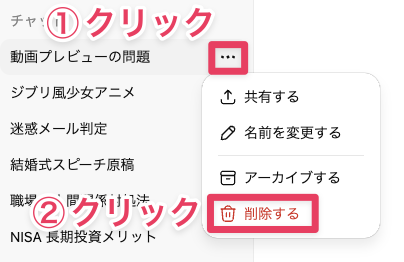

まず会話履歴については、手動で削除できるので、定期的に不要な会話を削除する習慣をつけましょう。サイドバーの会話のタイトルの右側にある「…」→「削除」をクリックすれば、すぐに削除できます。特に機密性の高い内容について相談した場合は、その都度削除することをおすすめします。

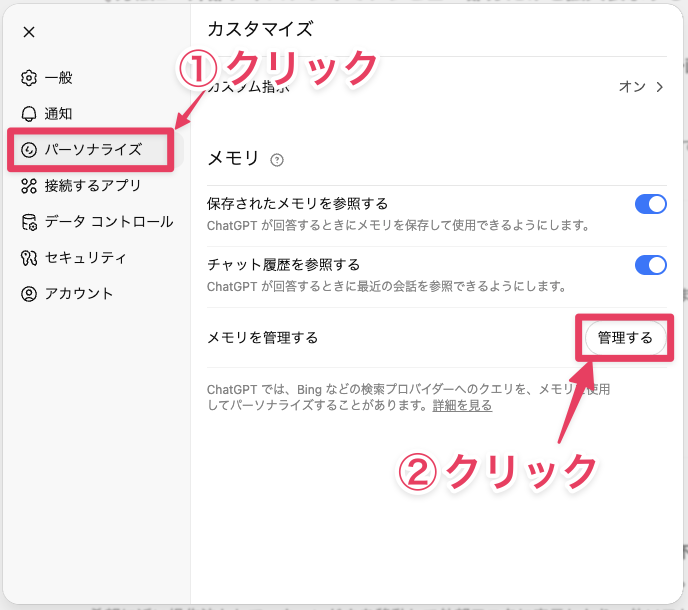

さらに注意したいのが「メモリ機能」です。これは2024年に追加された機能で、ChatGPTがあなたの好みや過去の会話内容を記憶し、より個人に適した回答を提供するためのものです。重要なのは、このメモリは会話履歴を削除しても残り続けるという点。つまり、会話を削除したつもりでも、重要な情報がメモリに保存されている可能性があるんです。

メモリの確認・削除は、設定ダイアログで「パーソナライズ」→「管理する」をクリックします。

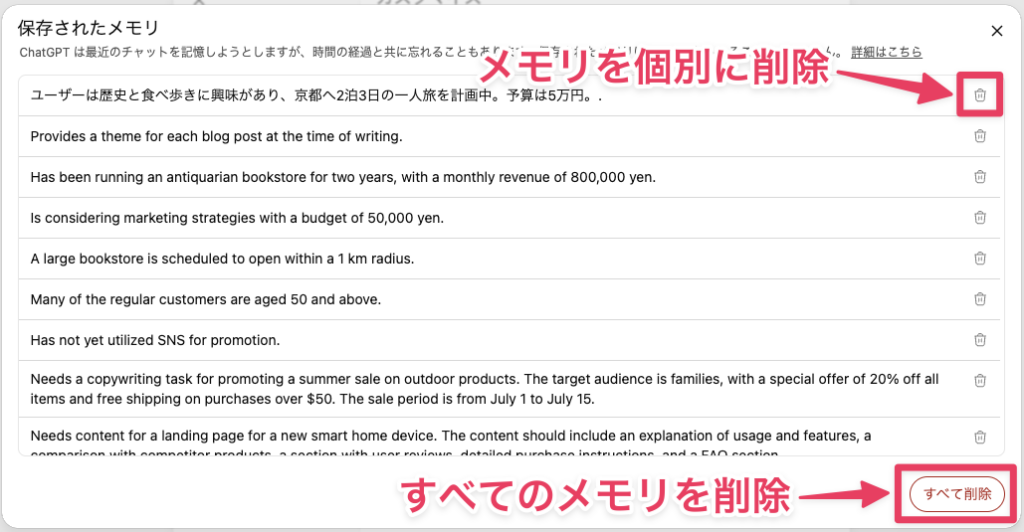

記憶されているメモリが一覧で表示されるので、不要な記憶は個別に削除できます。また、「ChatGPTのメモリをクリアする」ボタンで一括削除も可能です。

ただし、削除してもサーバー上で完全に消去される保証はないという点も理解しておくべきでしょう。

プライバシー設定を定期的にチェックする

最後に、プライバシー設定の確認についてです。OpenAIは定期的にプライバシーポリシーや設定項目を更新しているため、月に1回程度は設定画面をチェックして、新しいオプションが追加されていないかを確認しましょう。特に新機能が追加された際は、デフォルトでデータ収集がオンになっている可能性もあるため、注意が必要です。

企業や仕事で使う場合は?

もし勤務先でChatGPTの導入を検討している場合や、業務での利用が許可されている場合は、個人利用とは異なる注意点があることを覚えておいてください。

企業では利用ガイドラインの策定や従業員教育、場合によってはローカルAI(社内専用AI)の導入なども検討されています。もし職場でAIツールを使う機会があれば、必ず会社のルールを確認し、機密情報や顧客情報は絶対に入力しないよう注意しましょう。

前述したサムスン電子の事例のように、うっかりした情報入力が大きな問題に発展する可能性もあるため、業務利用の際は特に慎重な判断が求められます。

ローカルAIという選択肢

これまでの対策を実践しても、どうしてもプライバシーが心配という方には、ローカルAI(自分のパソコン内で動作するAI)という選択肢もあります。

ローカルAIは、インターネットに接続せずに自分のパソコン内だけでAIが動作するため、入力した情報が外部に送信される心配がありません。ChatGPTほど高性能ではありませんが、基本的な文章作成や翻訳、プログラミング支援などは十分可能です。

代表的なものとして「Ollama」や「LM Studio」などがあり、これらは無料で利用できます。ただし、ある程度高性能なパソコンが必要で、目安としてはメモリ16GB以上(32GB推奨)、CPUはIntel Core i7またはAMD Ryzen 7以上、NVIDIA製GPU(RTX 3060以上、VRAM 8GB以上)があるとより快適に動作します。

なお、最近話題のCopilot+PCに搭載されているNPU(AI専用プロセッサ)については、現在の主要なローカルAIツールではまだ十分に活用できていないのが現状です。将来的にはNPU対応が進むと予想されますが、現時点では従来のCPU・GPU構成の方が実用的と言えるでしょう。

興味のある方は、まずはこれらのツールについて調べてみることから始めてみてください。将来的により簡単に使えるローカルAIツールが登場する可能性も高いので、選択肢の一つとして覚えておくと良いでしょう。

まとめ:AI時代のリテラシーは「何を、どこまで、誰に」

今回アルトマンCEOの発言をきっかけに、ChatGPTのプライバシー問題についてまとめてきました。ここで重要なのは、AIとの会話には医師や弁護士との相談のような法的保護がないということを理解することです。

AI時代のリテラシーとして覚えておきたいのは、常に「何を、どこまで、誰に開示するか」を意識すること。便利さとリスクを天秤にかけて、賢く活用していくことが求められています。

個人の方は、プライバシー設定の見直しや入力内容の慎重な判断を心がけてください。企業の方は、ガイドライン策定や従業員教育、そして必要に応じてローカルAIの導入も検討してみてはいかがでしょうか。

AIは確実に私たちの生活を豊かにしてくれるツールです。その特性とリスクを正しく理解して使うことで、より安全で効果的な活用ができるはずです。